空間データ基盤における高精細な3Dモデルを復元するGaussian Splatting技術を用いた3Dスキャンシステム

- #データ/AI活用

工藤 忍(くどう しのぶ)

下山 拓流(しもやま たくる)

陳

思峰(ちん しほう)

田又 健士朗(たまた けんしろう)

山田

渉(やまだ わたる)

サービスイノベーション部

あらまし

従来,設備やインフラの現場状況をデジタル化する手段としてLiDAR機器やカメラが用いられてきた.しかし,LiDAR機器は高価であり,かつ専門知識も必要である.また,カメラで撮影した画像をマルチビューステレオ(MVS)により3Dモデルに復元する場合,複雑な形状の物体の正確な復元が難しい.そこでドコモでは,Gaussian Splatting技術を用いた3Dスキャンシステムの開発を進めている.本技術により,低コストかつ高精細な3Dモデルの作成をめざしている.

01.まえがき

通信や建築,不動産などさまざまな分野において,設備の維持管理の負担増大が問題となっている.この問題を解決するため,現実空間の情報を高度にデジタル化し分析する効率的な維持管理手法の確立が重要となる.こうした先進的な手法が確立されれば,その応用範囲は多岐にわたり,例えば,建築や不動産分野においては設計や施工,維持管理そして,製造業においては品質管理の効率化が期待される.

従来,設備やインフラなどの現実空間をデジタル化する手段として,主にLiDAR(Light

Detection And Ranging)*1機器を用いる方法とカメラを用いる方法があった.これらはいずれも有効な手段であるが,現実空間をデジタル化する上でそれぞれ課題がある.

LiDAR機器を用いて3Dモデルを作成する方法は,対象物までの距離を高精度に計測できる点で優れており,精密な3Dデータを取得するのに適している.しかし,LiDAR機器の,工事現場などで要求される測定精度を満たすモデルは数百万円から一千万円を超える価格帯で,高価であることが大きな課題となっている.また,LiDARの運用には専門的な知識が求められ,取得される点群*2データは極めて高密度に測定しない限り隙間が生じやすく,視認用途にはあまり適さないという問題もある.

一方,カメラを用いて3Dモデルを作成する方法は,複数の静止画や動画データを撮影し,マルチビューステレオ(MVS:Multi-View

Stereo)*3と呼ばれる三角測量の原理を利用して点群や3Dメッシュ*4を復元するものである.LiDARと比較して,安価なカメラのみで実装が可能なため,高いコスト効率を実現でき,短時間で広範囲の撮影が可能という利点がある.さらに,カメラは映像として記録するため,原画像を目で見て確認するような視認性が求められる用途にも適している.しかしこの方法では,樹木や細い線,網状の複雑な形状の物体や模様,凹凸の無い壁などはLiDARのように精密な形状を復元することが難しいという課題がある.

ドコモでは,上記の課題を解決するため,安価な全方位カメラとGS(Gaussian

Splatting)と呼ばれるフォトグラメトリー技術*5を活用し,その場にいるかのような高精細な3Dモデルを低コストで復元可能な3Dスキャンシステムの開発を進めている.

GSは,複数枚の画像から高精細な3D空間を構築する技術であり,従来のMVSと比べて高い視認性をもったレンダリング*6が可能で,リアルタイムレンダリングにも適している.本システムでは,このGSを活用し,従来のLiDARやMVSベースの3D復元技術と比較して,低コストかつ高精度な3Dモデルの構築をめざしている.

また,GSの実用性を高めるために2つの取組みを行っている.1つ目が安価な全方位カメラの活用である.360度を一度に撮影可能なカメラを適用することにより,撮影の手間を大幅に削減したシームレスなデータ取得を可能にする.2つ目が超解像技術*7を活用した高精細化である.GSの復元精度は入力画像の解像度に制約されるが,超解像技術により復元画像が入力画像を上回る精度の解像度を可能にする.

これらを適用した本システムにより,高精細な3Dモデルの復元にかかる導入コストを大幅に削減し,これまでコスト面で導入が難しかった業界へ導入することにより,施設管理・点検・視認用途における新たなサービス提供が期待できる.

本稿では,GS技術の概要,ドコモで開発中の2つの技術とその応用例について解説する.

- LiDAR:レーザー光を用いて対象物までの距離を測定し,3D点群を取得する手法.

- 点群:3D空間上に表される点の集合.

- マルチビューステレオ(MVS):複数の視点から撮影した画像を用いて,対象物の3D形状を復元する手法.

- 3Dメッシュ:三角形や四角形などのポリゴンで表される3Dモデル.

- フォトグラメトリー技術:画像から3Dモデルを復元する技術で,MVSなどが含まれる.

- レンダリング:3Dモデルを指定した視点から見た際の画像として出力する処理.

- 超解像技術:低解像度の画像から高解像度の画像を推定する技術.

02.GS技術の概要

GSはフォトグラメトリー技術の1つであり,入力した画像や映像を写実的な3D空間に復元することができる技術である[1].GSは,従来技術と比べて再現精度が高くレンダリング速度が速いことから大きな注目を集めている.以下ではその仕組みについて,概要を述べる.

2.1 GSの全体像

GSでは,ガウシアン*8状に拡散する点群(以下,ガウシアン点群)により3D空間を表現する.各点は,3D空間上の位置,拡散する方向,拡散の度合い,透明度のパラメータをもち,最適化*9により調整される.

ガウシアン点群の最適化の主な流れは下記のとおりである.

①撮影された画像(映像を用いる場合は画像に切り出す)のカメラ姿勢を推定する.

②ガウシアン点群の初期配置を行う.

③撮影された画像と同じカメラ姿勢からの見え方を2D画像としてレンダリングする.

④レンダリングされた画像と撮影画像の間で誤差を計算する.

⑤誤差を最小化するように,ガウシアン点群のパラメータを調整する.

⑥誤差が十分に小さくなるまで③ ~⑤を繰り返す.

2.2 撮影画像のカメラ姿勢推定

撮影された画像のカメラ姿勢を推定するには,SfM(Structure from Motion)*10やSLAM(Simultaneous Localization And Mapping)*11と呼ばれる技術を用いる.これらの技術により,画像の集合や映像から,各画像(映像の場合は各フレーム)のカメラ姿勢および特徴点の点群を得ることができる.

2.3 ガウシアン点群の初期配置

ガウシアン点群を初期配置する方法には大きく,SfMやSLAMで得られる点群をそのまま初期点として用いる方法と,ランダムに初期点を配置する方法の2つがある.一般には前者のほうが最適化の収束が早いことが知られており,多くの場合では前者の方法が採用されている.

2.4 3Dのガウシアン点群から2D画像のレンダリング

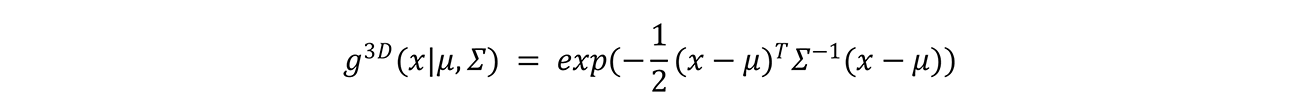

3Dのガウシアン点群g∈Gは,点群の中心座標を表す平均ベクトルμ∈R3およびガウシアン状の拡散の度合いを表す共分散行列*12Σ∈R3×3を用いて以下のように表される.

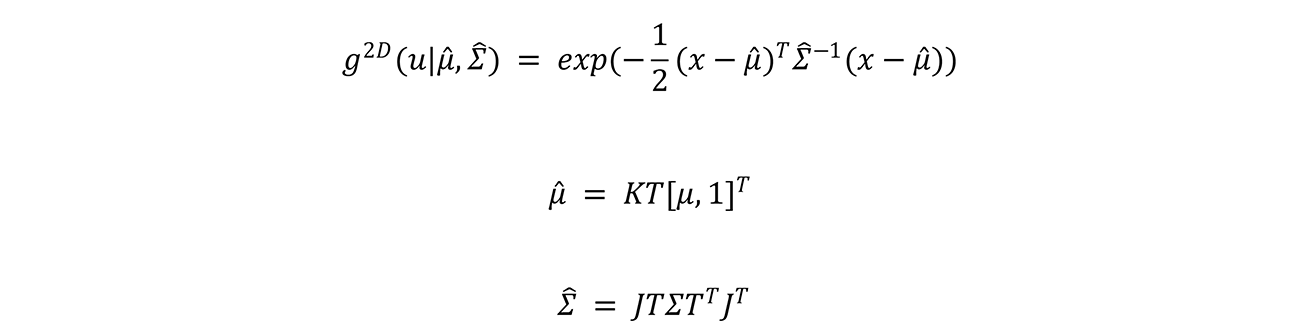

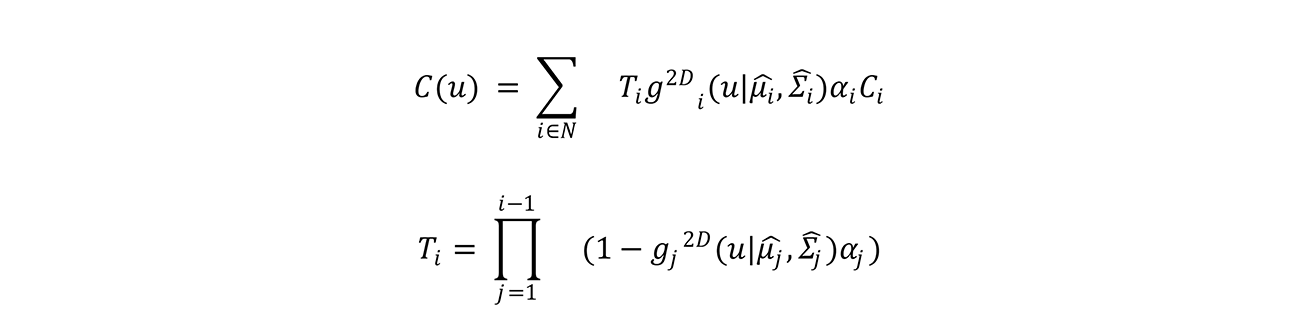

3Dのガウシアン点群から2D画像をレンダリングするにあたって,カメラの外部パラメータ行列Tおよび,投影行列Kで表されるカメラ姿勢を用いて,以下のように3Dのガウシアン点群を2Dに投影する.

ここで,Jは透視投影*13のアフィン近似*14ヤコビ行列*15である.

2Dに投影されたガウシアン点群から以下のように,レンダリングする画像の各ピクセル値C(u)を求める.

2.5 ガウシアン点群の最適化処理

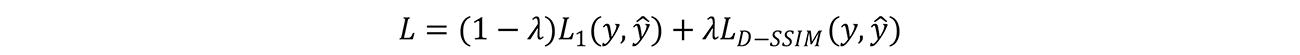

ガウシアン点群の最適化にあたっては,入力画像yとそれに対応するレンダリング画像y^のペアに対し,以下の誤差を計算し,これを最小化するようにガウシアン点群のパラメータを調整する.

L1はL1損失*16,LD-SSIMはD-SSIM(structural DiSSimilarity Index Measure)損失*17,λは重み係数*18である.

この処理を各撮影画像に対して誤差が十分小さくなるまで繰り返すことで,ガウシアン点群のパラメータが最適化され,写実的な3D空間を構築することが可能となる.

- ガウシアン:正規分布.

- 最適化:目的関数を最大化または最小化するために,パラメータなどを調整すること.

- SfM:フォトグラメトリーの1つで,複数の視点から撮影した画像からカメラの動きと3Dモデルを同時に推定する手法.

- SLAM:ロボットなどの自律的に移動するデバイスが自己位置を推定しながら周囲の3D形状を推定する手法.

- 共分散行列:各変数の分散を対角成分とし,その他の要素はそれぞれ2つの変数の変動方向(正・負)の相関を表す行列.

- 透視投影:3次元の物体を2次元の平面に投影する図法の1つ.

- アフィン近似:線形変換と並行移動の組合せであるアフィン変換で,一般の関数を近似すること.

- ヤコビ行列:多変数のベクトル値関数において,ある点におけるそれぞれの成分関数のそれぞれの変数に関する偏微分係数を成分とする行列.

- L1損失:予測値と正解値の誤差の絶対値を評価する損失関数.

- D-SSIM損失:画像構造に着目して画像同士の類似度を評価するSSIM(*29参照)を用いて,予測画像と正解画像の誤差を評価する損失関数.

- 重み係数:各種損失関数の寄与度を調整するための係数.

03.開発技術1:全方位カメラを用いたGSシステム

3.1 なぜ全方位カメラで撮影するのか

GSに限らず実世界の3Dモデルを構築するためには,3Dモデルを作成する対象をあらゆる方向からカメラでくまなく撮影する必要がある.例えば,手前の物体により奥の物体が隠れてしまう場合や,物体の裏側などカメラから映らない場合があり,そのような箇所のデータを取得するためにはカメラを持って歩き回り,さまざまな方向から撮影する必要がある.

しかし,一般的に広く普及する標準レンズを使用した単眼カメラ(以下,標準カメラと呼び,このカメラで撮影された画像を標準画像と呼ぶ)の画角は約46度であるため,実世界をくまなく撮影するためには非常に時間を要する.加えて撮影の際,3Dモデルの復元に失敗しやすい画像を撮影しないように注意して撮影する必要がある.例えば,模様や凹凸の少ない壁のみが写った画像を撮影してしまうと,その画像のカメラ姿勢推定に失敗する可能性が高く,3Dモデルの復元に悪影響を与えてしまう.そのため,撮影時には,復元に失敗しやすい箇所を避けて撮影するよう注意が必要であり,専門的なスキルが求められる.

ドコモでは,実世界の3Dモデルを構築する際の撮影の手間や難しさを改善するため,全方位カメラを用いたGSシステムを開発した.全方位カメラは,すべての方向の写真を一度に撮影することができるカメラである.特に全天球型の全方位カメラであれば前後上下左右すべての方向の写真を撮影可能であるため,さまざまな方向を向いて撮影する必要が無くなり,撮影時の手間を大幅に削減することが可能となる.また,前述したように模様や凹凸の少ない壁などの3Dモデルの復元に失敗しやすい箇所のみを撮影する可能性が低くなるため,専門のスキルをもたずに撮影可能である.

3.2 全方位カメラのGS適用フロー

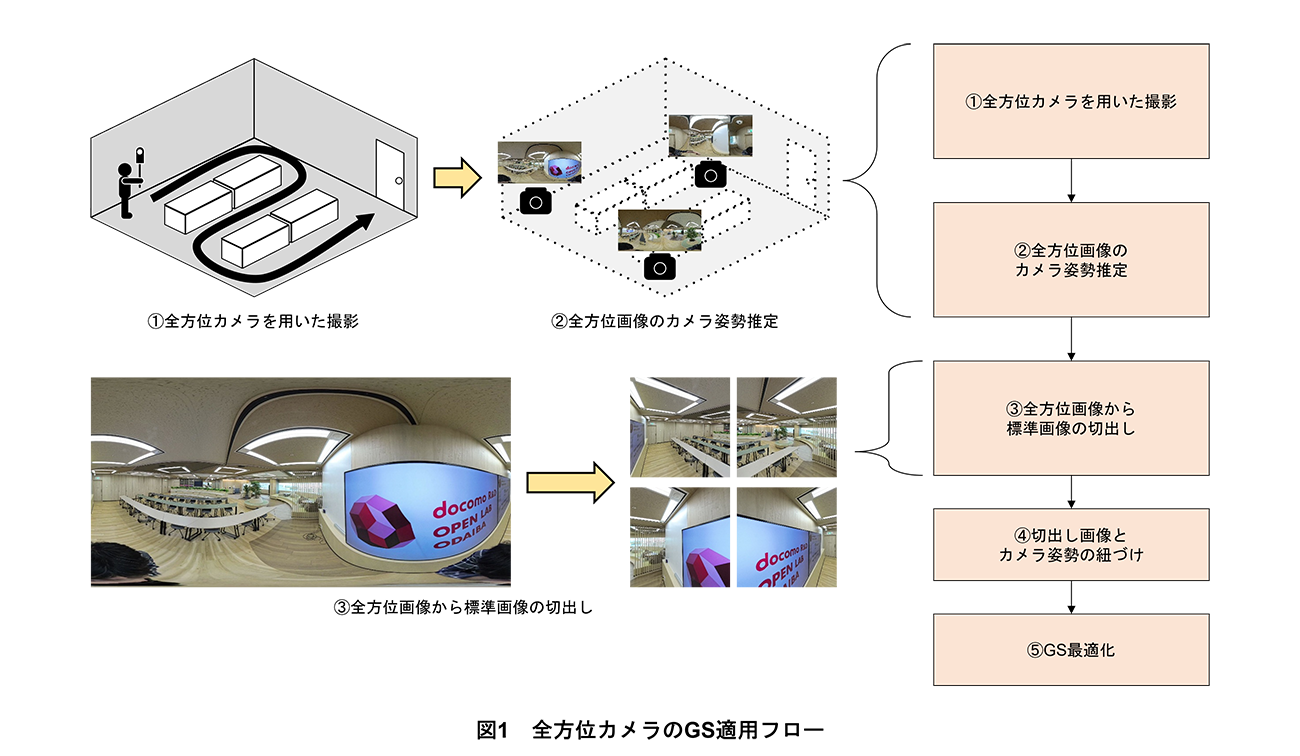

全方位カメラで撮影したデータにGSを適用するフローを図1に示す.開発技術は以下の5つの処理で構成される.

①全方位カメラを用いた撮影

まず,全方位カメラを用いた撮影では,全方位カメラで部屋全体を秒速0.5m程度でゆっくり歩き回ることにより部屋全体を動画で撮影する.

②全方位画像のカメラ姿勢推定

次に,動画から所定の時間間隔で全方位画像を切り出し,各全方位画像のカメラ姿勢およびガウシアン点群の初期配置に使用するための初期点群を推定する.

③全方位画像から標準画像の切出し

全方位画像の歪みを考慮するため標準画像と同じ画角で全方位画像から画像の切出しを行う.

④切出し画像とカメラ姿勢の紐づけ

切出し画像とカメラ姿勢の紐づけを行う.

⑤GS最適化

推定した全方位カメラ姿勢とその位置から撮影された全方位画像から切り出された標準画像,初期点群を用いてGS最適化を実施する.

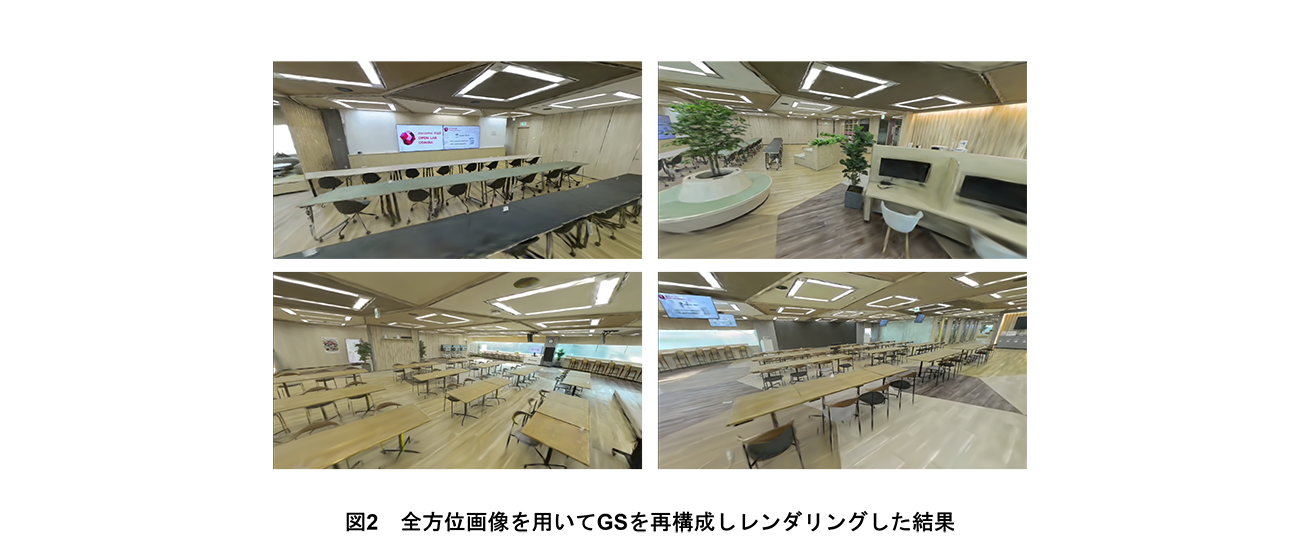

3.3 全方位画像によるGS結果

全方位画像をGSに適用可能であることを確認するため,実際に全方位カメラ(Insta

360

X4®)を用いて約300m2の広さの室内空間を撮影し,その映像から3Dモデルの作成を行った.

撮影した全方位画像を用いて再構成したGSのレンダリング結果を図2に示す.図2からは,3D形状や見た目が正確に再構成されていることが確認できる.また,欠損も見られず,見た目も不安定になっていない.これを標準カメラで実現するためには,さまざまな位置や角度からの撮影が必要となり,同じ空間を撮影するだけでも1時間以上を要する.一方,今回の全方位カメラによる撮影では,撮影時間を約20分に抑えることができ,大幅な時間短縮を実現した.

04.開発技術2:超解像技術を用いたGSの高精細化技術

4.1 背景

GSの復元精度は撮影画像の品質に依存するため,入力画像よりも高い周波数成分*19(細かなディティール)を復元できない.そのため,被写体に対してレンダリング視点を撮影視点よりも近づけると,近景を精細に描画するための情報が不足しているため,画像がのっぺりするなど,レンダリング画像の品質が低下するという問題が生じる.これは被写体に対して,より近づいた視点での撮影を実施することで解決可能であるが,撮影枚数が増えるため撮影コストが大幅に増加してしまう.

この課題に対し,超解像技術によって高解像度化した画像を用いてGS復元を行う手法がいくつか提案されている[2]~[4].その中でも,SRGS(Super-Resolution

3D Gaussian

Splatting)[4]と呼ばれる手法では,高解像度化した画像を用いるだけでなく,画像の劣化過程モデル*20を考慮することで復元精度の向上を実現している.

SRGSでは,画像の劣化過程を平均カーネル*21によるダウンサンプリング(DS:DownSampling)*22でモデル化している.しかし,実際の劣化過程はカメラの機種や撮影条件によって異なるため,撮影時の劣化過程がこのモデルと異なる場合には復元精度が低下するという問題がある.

そこで,ドコモでは,SRGSの劣化過程を,学習可能なパラメータをもつ劣化過程モジュールでモデル化し,GSパラメータの学習と同時に実際の劣化過程を推定することで,SRGSの課題を解決し,高精細な3Dモデルを復元する技術を開発した.

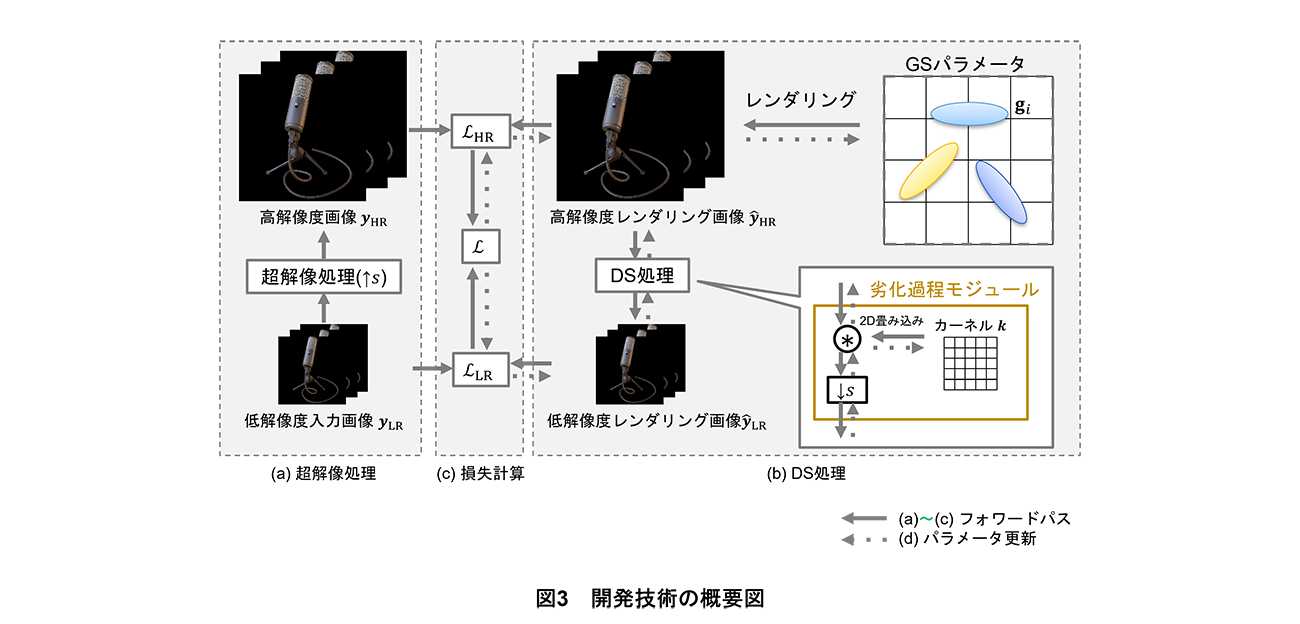

4.2 開発技術

開発技術の概要図を図3に示す.開発技術は以下の4つの処理で構成される.

①超解像処理(図3(a))

②DS処理(図3(b))

③損失計算(図3(c))

④パラメータ更新(図3(d))

まず,超解像処理では,低解像度入力画像yLRを所定のスケールファクターsで超解像処理を施し,高解像度画像yHRを算出する(図3(a)).そして,DS処理では,高解像度レンダリング画像yHR^をレンダリングし,後述の劣化過程モジュールを用いて低解像度レンダリング画像yLR^を算出する(図3(b)).次に,高解像度損失LHR=(1-λ)L1 (yHR , yHR^)+λLD-SSIM (yHR , yHR^)と低解像度損失LLR=(1-λ)L1 (yLR , yLR^)+λLD-SSIM (yLR , yLR^)を算出し,それらを重み係数λeにより線形結合*23することで損失関数L=(1-λe ) LHR+λeLLRを計算する(図3(c)).最後に,損失関数Lを最小化する最適化処理によりGSパラメータと劣化過程モジュールを学習する(図3(d)).

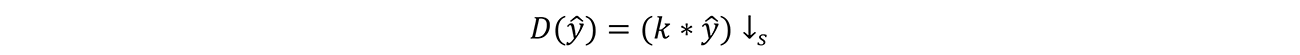

劣化過程モジュールは入力画像取得における実際の劣化過程を推定するモジュールである.画像の劣化過程は一般的にカーネルを用いた2D畳み込み*24とDS処理によってモデル化できるため,開発技術では次式のようにn×nサイズの学習可能なカーネルkをパラメータとして劣化過程モジュールDを定義する.

ここで,*は2D畳み込み演算子,↓sはスケールファクターsでのDS処理を表す.

以上の処理により,SRGSでは行えていなかった実際の劣化過程に即した学習が可能となり,より適切なGSパラメータの最適化が行えるため,高精細な3Dモデルの復元が実現できる.

4.3 評価実験

開発技術の有効性を検証するために合成データセット*25[5]を用いて評価実験を行った.

(1)実験条件

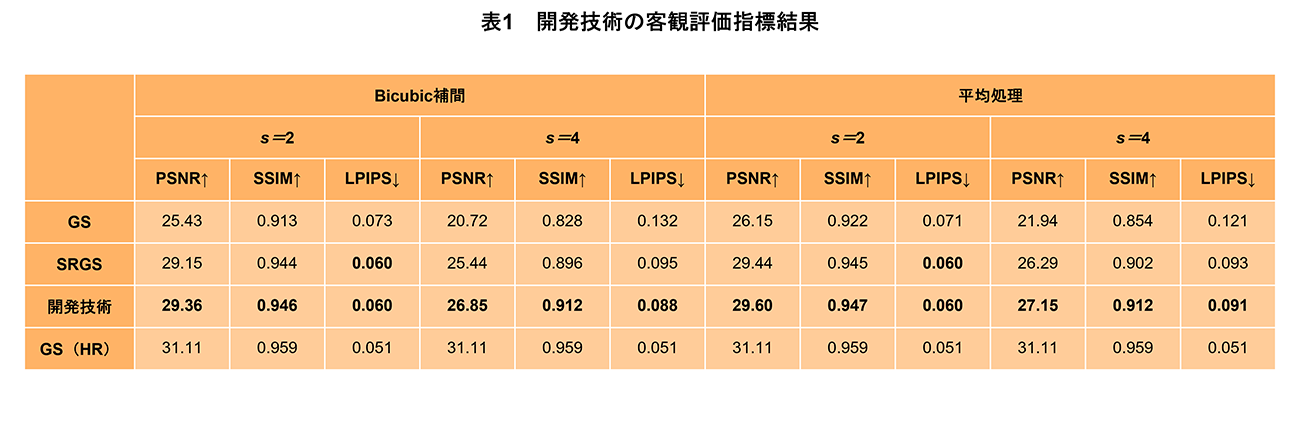

①評価指標*26

データセットをそれぞれスケールファクター*27s=2,s=4でDSしたものを入力画像として元の解像度に復元処理を行った.元の解像度のデータを教師データとし,PSNR(Peak

Signal-to-Noise Ratio)*28,SSIM(Structural Similarity Index Measure)*29[6]および,LPIPS(Learned Perceptual Image Patch Similarity)*30[7]の3つの評価指標で再現品質を評価した.

②比較対象手法

開発技術をGS[1]および,SRGS[4]の2つの手法と比較した.DS処理については,Bicubic補間*31と平均処理*32の2つの方法を用いてそれぞれの手法を適用した.また,参考として性能限界を示すために,元の解像度のデータを直接用いてGS[1]を学習した場合(GS(HR)と表記)も比較した.

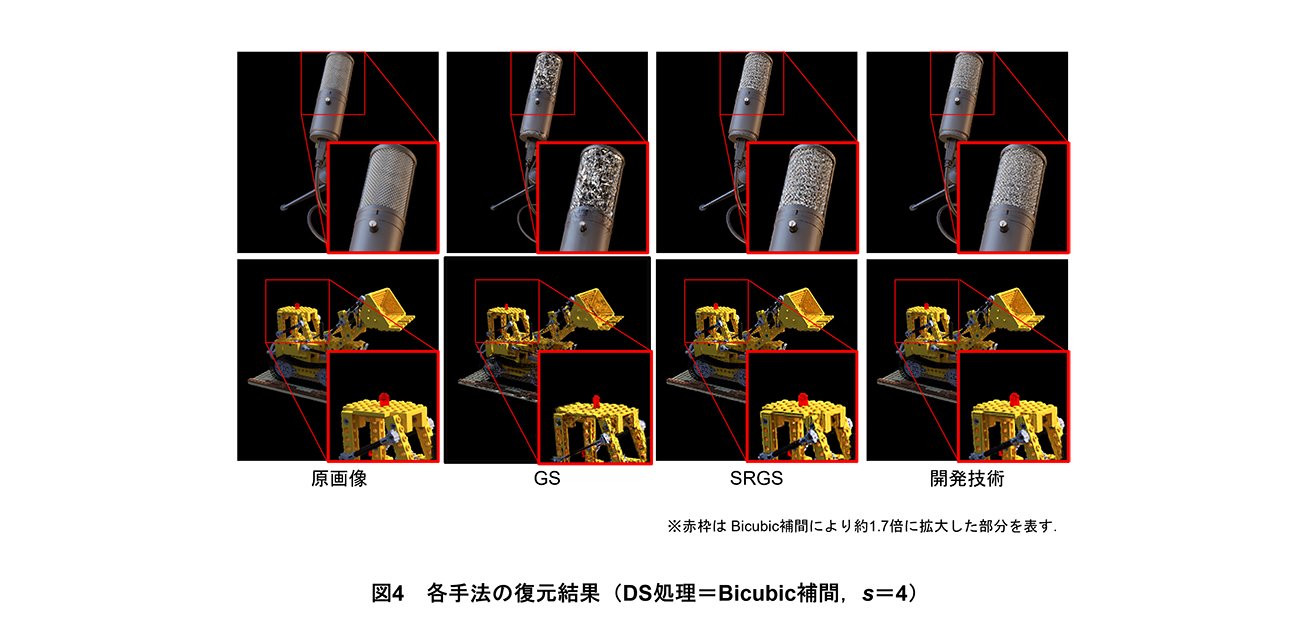

(2)実験結果

評価結果を表1と図4に示す.表1で示されるとおり,開発技術はすべての評価指標についてGS,SRGSを上回る結果となった.特にs=2よりもs=4の場合で改善率が大きく,SRGSに対してはPSNRで最大1.4ポイント改善した.これはs=4のときに劣化過程モデルと実際の劣化過程でのかい離の影響が大きかったためと考えられる.DS処理については,Bicubic補間したデータに適用した場合に,実際の劣化過程と異なるモデルを使用しているため,SRGSは大きな性能低下となっている.一方で,開発技術はすべてのDS処理について安定して高い復元精度を示している.

これらの結果は図4のとおり,視覚的にも示されている.図4ではGSおよびSRGSは,原画像と比較して高周波数成分がうまく再現できておらず,特にマイクの網部分が破綻し主観的に違和感のある復元結果となっている.一方で,開発技術はその他の手法と比較して高周波数成分を正しく復元できていることが確認された.

- 周波数成分:画像において,輝度値の変化の細かさ具合を表す要素.

- 劣化過程モデル:画像を取得する際に引き起こされたノイズなどの劣化を表したモデル.

- カーネル:画像に畳み込み処理などを行うための重み係数.

- ダウンサンプリング(DS):間引きなどにより画像やデータの解像度を下げる処理.

- 線形結合:ベクトルの線形和.ベクトルの定数倍と加え合わせのこと.

- 2D畳み込み:画像に対してカーネルを用いてフィルタをスライドさせながら適用し,新たな画像や特徴を計算する演算.

- 合成データセット:CGなどで作られた特定の目的や分析のために収集されたデータの集まり.

- 評価指標:物事の良し悪しを数値で表すための尺度.

- スケールファクター:画像を拡大,縮小する際の倍率.

- PSNR:画素値の二乗誤差を用いて画質の劣化度合いを測る客観的評価指標.

- SSIM:画像の構造的な類似性を用いて画像の類似性を測る客観的評価指標.

- LPIPS:深層学習モデルを用いて画像の類似性を測る客観的評価指標.

- Bicubic補間:画像の拡大,縮小時に周囲の4×4のピクセル情報を用いて補間する手法.

- 平均処理:フィルタ内の平均値を計算する処理.

05.応用例

これまでに,全方位カメラを用いたGSシステムおよびその高精細化技術について述べてきたが,GSは任意のカメラで撮影された映像があれば高精細で視認用途に適した3Dモデルを復元できる点が,LiDARやMVSにはない大きな利点である.そのため,カメラを搭載した他の機器を活用することも可能である.

ここではその応用例として,ドローンおよびスマートフォンを用いた事例を紹介する.図5(a)は,ドローンで廃校を上空から撮影した映像を基に復元した結果,図5(b)は,市販のスマートフォンで建機の周囲を撮影したデータを基に復元した結果である.

06.あとがき

本稿では,3Dスキャン技術の現状と課題を整理し,それを解決するためのドコモの取組みについて述べた.従来の3Dスキャン技術として一般的に用いられてきたLiDARやMVSには,それぞれコストや復元精度に関する課題があった.本システムでは,GSを活用し,低コストかつ高精細な3D復元を実現することをめざしている.

また,GSの有効性を最大限に引き出すため,全方位カメラによるシームレスな撮影および超解像技術による細部の復元精度向上を導入することにより,3Dスキャンの適用範囲を拡大することに成功した.これにより,建築や不動産の維持管理,さらにはインフラ設備の点検,遠隔での状況確認など,これまでコストや手間が課題となっていた分野での実用化が期待される.

今後,本システムのさらなる実用化に向けて,撮影環境の最適化,データ処理の高速化,リアルタイムでの3D表示技術の強化など,さまざまな技術開発を進めていく.3Dスキャン技術の進化により,より精密かつリアルなデジタルツイン*33の構築が可能となり,デジタル空間の活用がさらに広がることが期待される.

- デジタルツイン:現実世界に存在する場所,モノや事象を,さまざまなデータを基にデジタル空間上に双子のように再現する技術.

文献

-

[1] B. Kerbl, G. Kopanas, T. Leimkuehler and G. Drettakis:“3D Gaussian Splatting for Real-Time Radiance Field Rendering,”ACM Transactions on Graphics (TOG), Vol.42, Issue.4, pp.1-14, Jul. 2023.

-

[2] C. Wang, X. Wu, Y.-C. Guo, S.-H. Zhang, Y.-W. Tai and S.-M. Hu:“NeRF-SR: High Quality Neural Radiance Fields using Supersampling,”MM '22: Proceedings of the 30th ACM International Conference on Multimedia, pp.6445-6454, Oct. 2022.

-

[3] Y. Yoon and K.-J. Yoon:“Cross-Guided Optimization of Radiance Fields with Multi-View Image Super-Resolution for High-Resolution Novel View Synthesis,”2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp.12428–12438, Jun. 2023.

-

[4] X. Feng, Y. He, Y. Wang, Y. Yang, W. Li, Y. Chen, Z. Kuang, J. Ding, J. Fan and Y. Jun:“SRGS: Super-Resolution 3D Gaussian Splatting,”arXiv preprint arXiv:2404.10318, Jun. 2024.https://arxiv.org/abs/2404.10318

-

[5] B. Mildenhall, P. P. Srinivasan, M. Tancik, J. T. Barron, R. Ramamoorthi and R. Ng:“NeRF: representing scenes as neural radiance fields for view synthesis,”Communications of the ACM, Vol.65, Issue.1, pp.99-106, Dec. 2021.

-

[6] Z. Wang, E. P. Simoncelli and A. C. Bovik:“Multiscale structural similarity for image quality assessment,”The Thirty-Seventh Asilomar Conference on Signals, Systems & Computers, Vol.2, pp.1398–1402, Nov. 2003.

-

[7] R. Zhang, P. Isola, A. A. Efros, E. Shechtman and O. Wang:“The Unreasonable Effectiveness of Deep Features as a Perceptual Metric,”2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp.586–595, Jun. 2018.